扫码分享到微信

2026年1月29日,Wiki Education发布了一份关于生成式AI对维基百科编辑影响的深度报告。作为一个致力于大规模招募新编辑的组织,Wiki Education负责了英文维基百科约19%的新活跃编辑。正是基于这样的规模,他们对新编辑面临的挑战——以及如何帮助他们成功编辑——有着深刻的理解。

2022年11月ChatGPT发布后,随着越来越多的人开始在日常生活中使用生成式AI聊天机器人,如ChatGPT、Gemini或Claude,人们开始考虑用这些工具来帮助起草维基百科的贡献内容,这并不令人意外。Wiki Education的项目提供了一个可以评估的内容创作者群体,他们开始调查参与者如何使用生成式AI工具。

在开放维基媒体运动的环境中,分享经验很重要。Wiki Education希望通过这份博客文章来帮助inform关于维基百科上生成式AI内容的讨论。他们的学习成果可以帮助那些试图保护百科全书内容完整性的维基百科编辑、对使用生成式AI工具感兴趣的维基人、全球其他试图让可能使用这些工具的新贡献者上线的项目领导者,以及维基媒体基金会——其产品和技术团队正在构建软件来帮助支持维基百科上高质量内容的发展。

核心结论:维基百科编辑绝不应将ChatGPT等生成式AI聊天机器人的输出复制粘贴到维基百科文章中。

AI检测与调查

自2022年11月ChatGPT发布以来,Wiki Education一直密切关注生成式AI创建的内容,以及它与维基百科的关系。他们对来自项目的新编辑的工作进行了抽查,主要关注引用以确保它们是真实的而非幻觉生成的。他们自己试验了工具,为项目参与者主持了关于生成式AI的视频会议,并密切关注维基百科上关于生成式AI的政策讨论。

目前,英文维基百科禁止使用生成式AI创建图像或在讨论页中使用,并最近采用了禁止使用大型语言模型生成新文章的指导方针。

当Wiki专家Brianda Felix和Ian Ramjohn在2025年上半年与项目参与者合作时,他们在文章内容中发现了越来越多带有生成式AI标志的文本,比如奇怪的加粗或项目符号列表。但生成式AI的使用不一定是有问题的,只要内容是准确的。维基百科的开放编辑过程鼓励对事实文本进行风格修订,以更好地适应维基百科的风格。

但文本在事实上是否准确?这个根本性问题导致了首席技术官Sage Ross调查不同的生成式AI检测器。他最终选择了一个叫Pangram的工具,他们发现对于维基百科文本高度准确。

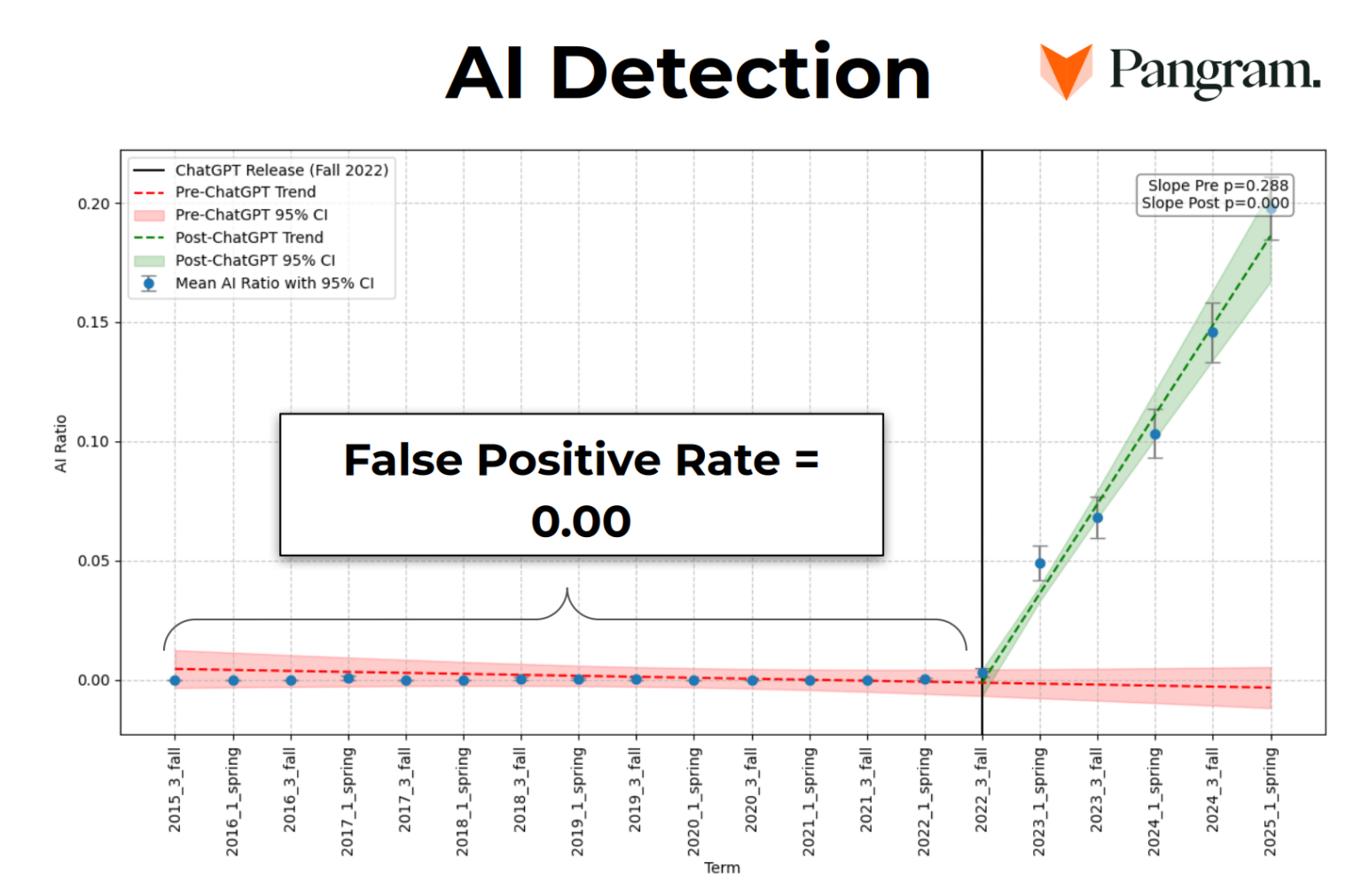

Sage生成了自2022年以来通过他们的工作创建的所有新文章的列表,并将它们全部通过Pangram运行。在3,078篇文章中,有178篇被标记为AI生成的——在2022年11月ChatGPT发布之前没有一篇,从那以后的每个学期都呈现增加的百分比。

Wiki Education大约一半的员工在2025年夏季花了一个月的时间, 煞费苦心地地审查这178篇文章的文本。Pangram的检测结果显示,在ChatGPT发布之前没有AI使用的迹象,然后在随后的学期中稳步上升。

基于围绕AI幻觉的讨论,他们预期这些文章会包含对不存在来源的引用,但事实并非如此:只有7%的文章有虚假来源。其余的信息引用了真实、相关的来源。

然而,更隐蔽的是他们发现的另一件事:超过三分之二的这些文章未能通过验证。这意味着文章包含一个听起来合理的句子,引用了一个真实、听起来相关的来源。但当你阅读它引用的来源时,维基百科上的信息在那个特定来源中并不存在。当声明未能通过验证时,不可能判断信息是真是假。

对于Pangram标记为生成式AI编写的文章,几乎每个引用的句子都未能通过验证。这一发现导致Wiki Education投入大量员工时间来清理这些文章——远比这些编辑创建它们可能花费的时间更多。

Wiki Education的核心使命是改善维基百科,当他们发现他们的项目无意中为维基百科上的错误信息做出了贡献时,他们致力于清理它。在清理过程中,Wiki Education员工将最近的工作移回沙盒,将那些通过了重要性但主要未能通过验证的文章存根化,并删除了一些他们判断无法挽救的文章。

(虽然对维基百科的删除过程有很多抱怨,但他们发现,由于完全是幻觉的生成式AI内容,他们删除的一些文章被其他编辑撤销了删除,显示了维基百科社区对生成式AI的多样性意见。)

修订指导方针

鉴于他们通过调查之前学期的工作所发现的,以及生成式AI使用的增加,Wiki Education希望主动解决项目中的生成式AI使用问题。感谢Pangram朋友的支持,他们开始几乎实时地将参与者的维基百科编辑(包括在他们的沙盒中)通过Pangram运行。这是可能的,因为Sage构建的Dashboard课程管理平台,它跟踪编辑并基于维基百科上的编辑为Wiki专家生成工单。

他们创建了一个全新的培训模块,关于使用生成式AI工具与维基百科。这个培训强调参与者可以在工作中使用生成式AI工具的地方,以及他们不应该使用的地方。这些培训的核心信息是:不要从生成式AI聊天机器人复制粘贴任何东西到维基百科。

他们为Pangram检测到正在添加生成式AI聊天机器人创建的文本的参与者制作了各种自动邮件。Sage还录制了一些视频,因为许多年轻人习惯通过视频而不是阅读文本来学习。他们还提供了与项目参与者互动和对话的机会。

2025年下半年的发现

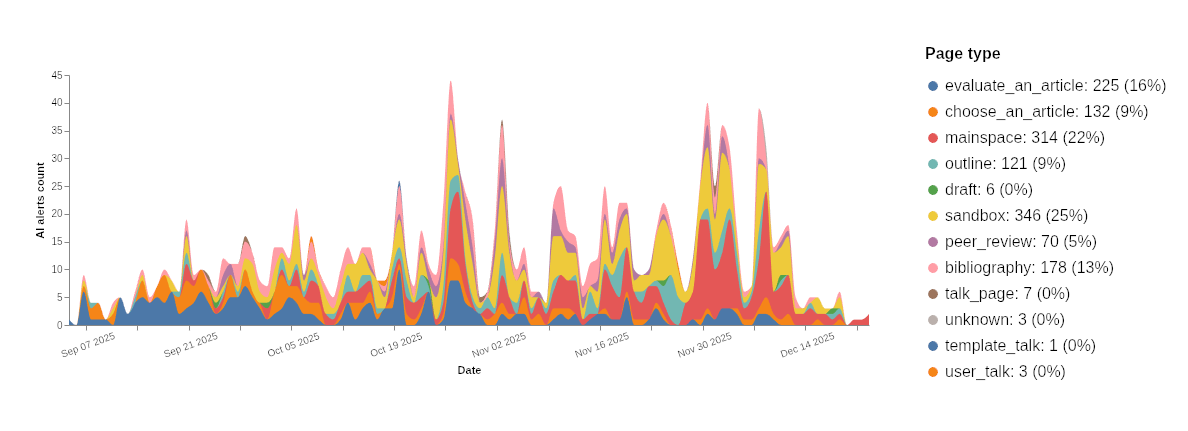

2025年下半年,他们共有1,406次AI编辑警报,尽管只有314次(22%)是在维基百科的文章命名空间中(即对已发布文章的编辑)。在大多数情况下,Pangram检测到参与者在早期练习期间的沙盒中使用生成式AI,当时要求他们做诸如选择文章、评估文章、创建参考书目和概述他们的贡献等事情。

Pangram在几种沙盒场景中误报:参考书目,通常是人类编写的散文(描述来源及其相关性)和非散文文本(来源的引用,某种标准格式)的组合;以及包含大量非散文内容(如项目列表、节标题、文本片段等)的大纲。

他们还有少数情况,参与者在编辑或扩展现有文章后,从现有文章复制了AI编写的章节作为起点,导致沙盒被标记为AI。(这不是Pangram的缺陷,而是提醒他们,项目之外的编辑正在向维基百科添加多少AI生成的内容!)

总体而言,他们发现Pangram擅长分析纯散文——维基百科文章正文中会发现的那种句子和段落类型——但有时会被格式、标记和非散文文本绊倒。早期,他们禁用了参与者参考书目和大纲练习的警报邮件,并且在2025年底,他们改进了Dashboard的预处理步骤,在将修订发送给Pangram之前提取散文部分并将其转换为纯文本。

许多参与者还报告说"只是使用Grammarly进行复制编辑"。根据他们的经验,Grammarly做的最小修复从未触发Pangram的检测,但如果使用其更高级的内容创建功能,生成的文本会被注册为AI生成。

但总体而言,他们对Pangram的结果感到满意。他们对标记为在不会进入文章空间的练习中使用生成式AI的参与者的早期干预,似乎阻止了他们对生成式AI的未来使用。2025年秋季,他们支持了6,357位新编辑,其中只有217位(3%)有多次AI警报。只有5%他们支持的参与者有文章空间AI警报。这意味着数千名参与者在没有使用生成式AI起草内容的情况下成功编辑了维基百科。

对于那些确实添加了生成式AI起草文本的人,他们确保内容被回滚。事实上,参与者有时会在收到邮件后自我回滚,让他们知道Pangram检测到他们的贡献是AI创建的。讲师也跳进去回滚,一些维基百科人自己发现了内容。他们的工单系统还向Wiki专家员工发出警报,他们尽快回滚了文本。

虽然维基百科学生项目中的一些讲师对AI检测有担忧,但他们在围绕可验证性概念进行对话方面取得了很大成功。如果讲师作为主题专家可以证明信息是准确的,并且他们可以在引用的来源中找到具体事实,他们允许文本回到维基百科。然而,尝试验证学生创建的工作(在许多情况下,学生发誓是他们自己写的)的过程导致许多讲师意识到他们在自己的评估中发现的:在当前状态下,生成式AI驱动的聊天机器人无法为维基百科编写事实准确的、可验证的文本。

他们相信基于Pangram的检测干预导致更少的参与者向维基百科添加生成式AI创建的内容。遵循趋势线,他们预期约25%的参与者向维基百科文章添加生成式AI内容;实际上,只有5%,并且他们的员工能够回滚所有有问题的内容。

LiAnna Davis表示:"我深深感谢让这一成功成为可能本学期的每一个人:遵循我们建议的参与者,给予我们检测服务访问权限的Pangram,完成处理所有阳性检测繁重工作的Wiki Education员工,以及维基百科社区,其中一些人在我们之前发现了我们项目参与者的有问题的作品。"

生成式AI如何提供帮助?

到目前为止,LiAnna Davis专注于生成式AI创建内容的问题。但这并不是这些工具所能做的全部,他们确实发现了一些有用的方法。

他们的培训模块鼓励编辑——如果他们的机构政策允许的话——考虑使用生成式AI工具来:识别文章中的空白;查找访问来源;查找相关来源。

为了评估这些使用场景的成功,他们直接与他们2025年秋季在维基百科学生项目中支持的7个班级合作。他们要求学生在每次在维基百科工作中使用生成式AI工具时匿名填写调查。他们询问了使用什么工具、使用什么提示、如何使用输出以及是否有帮助。

虽然一些学生多次填写调查,其他人只填写了一次。他们有102次回应报告在项目的各个阶段的使用。绝大多数,87%报告使用生成式AI的回应表示这对他们的任务有帮助。

迄今为止最受欢迎的工具是ChatGPT,其次是Grammarly,其他的都是个位数的使用。学生报告AI工具在以下方面非常有帮助:识别与他们正在修读的课程相关的文章;突出现有文章中的空白,包括缺失的章节或更最近缺失的信息;找到他们尚未找到的可靠来源;指出某个期刊文章可以在哪个数据库中找到;当用他们起草的文本和要求清单提示时,根据这些要求评估草稿;识别他们可以添加到编辑的文章的类别;纠正语法和拼写错误。

关键的是,没有参与者报告使用AI工具为他们的作业起草文本。一名学生报告:"我将我在沙盒中的所有写作粘贴出来,说'把这个放在一个更随意、不那么学术的语气'……我想试试,但它听起来不像我通常写的,我觉得它没有捕捉到我想要表达的东西,所以我放弃了。"

虽然这是一个非正式的研究项目,但他们收到了足够的积极反馈,相信在研究阶段使用ChatGPT和其他工具可能会有所帮助,如果编辑随后批判性地评估他们获得的输出,而不是盲目接受。即使发现AI有帮助的参与者也报告他们没有使用它给他们的所有东西,因为有些是不相关的。毫无疑问,在整个过程中保持人类思考组件至关重要。

这对Wiki Education意味着什么?

LiAnna Davis的结论是,至少就现在而言,像ChatGPT这样的生成式AI驱动的聊天机器人绝不应该用于为维基百科生成文本;其中太多内容将根本无法验证。他们的员工将花费更多时间尝试验证AI生成文章中的事实,而不是如果他们自己做研究和写作。

话虽如此,AI工具可以在研究过程中提供帮助,特别是帮助识别内容空白或来源,当与仔细评估信息的人类大脑结合使用时。编辑绝不应该简单地接受聊天机器人的建议;相反,如果他们想使用聊天机器人,他们应该将其用作头脑风暴合作伙伴,帮助他们思考文章的计划。

迄今为止,随着他们的项目参与者编辑维基百科,Wiki Education的干预在将无法验证的、生成式AI起草的内容拒之门外方面显示出前景。基于秋季学期的经验,他们对Pangram作为AI内容检测器——至少对于维基百科文章——有很高的信心。他们将在2026年继续当前策略(进行更多小调整,以使系统尽可能可靠)。

更普遍地说,他们发现参与者的AI素养比流行话语可能暗示的要低。正因为如此,他们创建了一个补充的大型语言模型培训,已作为所有参与者的可选模块提供。许多参与者表明,他们发现我们关于AI的指导在他们试图驾驭AI工具创造的新复杂性时是受欢迎和有帮助的。

他们也期待更多关于他们工作的研究。由普林斯顿大学的Francesco Salvi和Manoel Horta Ribeiro、密西西比大学的Robert Cummings以及Wiki Education的Sage Ross组成的研究团队——一直在研究Wiki Education维基百科学生项目编辑者对生成式AI的使用随时间的变化。初步结果支持了他们的轶事理解,同时也揭示了自生成式AI聊天机器人推出以来,学生创作的文本如何变化的细节。他们还确认了对Pangram的信念:在没有涉及任何日期信息的情况下,将通过Pangram运行从2015年直到ChatGPT推出之前的学生编辑后,团队发现Pangram正确识别了所有内容都是100%人类编写的。这项研究将继续到春季,因为团队探索解开AI对文章质量不同方面影响的方法。

当然,生成式AI是一个快速变化的领域。仅因为这些是2025年的发现并不意味着它们将在整个2026年成立。Wiki Education仍然致力于监控、评估、迭代和适应所需的调整。根本上,他们致力于确保通过他们的项目为维基百科添加高质量内容。当他们错过标记时,他们致力于清理任何损害。

这对维基百科意味着什么?

虽然LiAnna Davis在这篇文章中专注于Wiki Education通过与项目参与者合作学到的东西,但教训可以扩展到其他编辑维基百科的人。全球已有10%的成年人使用ChatGPT,起草文本是顶级用例之一。随着生成式AI使用的普及,善意的人用它来为维基百科起草内容也会增加。

长期、日常的维基百科编辑不太可能添加从生成式AI聊天机器人复制粘贴的内容,而不验证它引用的所有信息都在来源中。但许多随意的维基百科贡献者或新编辑在使用聊天机器人时可能会无意中向维基百科添加不良内容。毕竟,它提供了看起来像准确事实的东西,引用的通常是真实、相关、可靠的来源。他们最终回滚的大多数编辑在粗略审查时似乎是可以接受的;只有在他们尝试验证信息后,他们才理解了问题。

因为这种无法验证的内容在第一次通过时似乎可以接受,所以维基百科编辑配备像Pangram这样的工具以更准确地检测他们何时应该仔细查看编辑至关重要。自动化对生成式AI使用的文本审查——就像维基百科人为版权侵权文本多年来所做的那样——将有助于保护维基百科内容的完整性。在Wiki Education的经验中,Pangram是一个可以为编辑提供准确文本评估的工具,他们希望看到为他们构建的评估来自项目编辑的工具的更大版本部署到维基百科的所有编辑中。

目前,编辑可以添加一个警告横幅,突出文本可能是LLM生成的,但这仅基于添加横幅的人的评估。他们的经验表明,仅凭语气判断是不够的;相反,像Pangram这样的工具可以标记应该立即回滚但听起来可以接受的高度有问题信息。他们还在为项目参与者创建的培训模块和支持中发现了成功。提供明确的指导——以及为什么存在这些指导的原因——一直是帮助他们阻止生成式AI文本不良使用的关键。他们鼓励维基百科人考虑修订对新贡献者在欢迎消息中的指导,强调添加生成式AI起草文本的陷阱。维基媒体基金会创建的新贡献者软件应该以从来源列表开始并使用人类智力而非生成式AI从中提取信息总结信息为中心。提前提供指导可以帮助善意贡献者避开不良的生成式AI创建的文本。

维基百科最近庆祝了它的25岁生日。为了在未来生存,它需要适应其周围技术的变化。维基百科没有其志愿编辑团队就什么都不是。维基百科基于共识的决策模型意味着变化不会很快到来,但他们希望这次深入探讨将有助于引发关于需要保护维基百科进入未来的变化的对话。(文/译/王子祺)